MiniMind

互联网

2025-03-10 20:42:11

MiniMind 是用低成本训练大语言模型的开源工具,从零开始,仅需 2 小时和 3 块钱,就能训练出 26M 参数的迷你 GPT 模型。

亮点

2 小时快速训练,适合个人 GPU 用户

仅需 3 块钱的服务器成本,超低门槛

提供完整训练代码,涵盖预训练、微调、蒸馏等全过程

项目包含

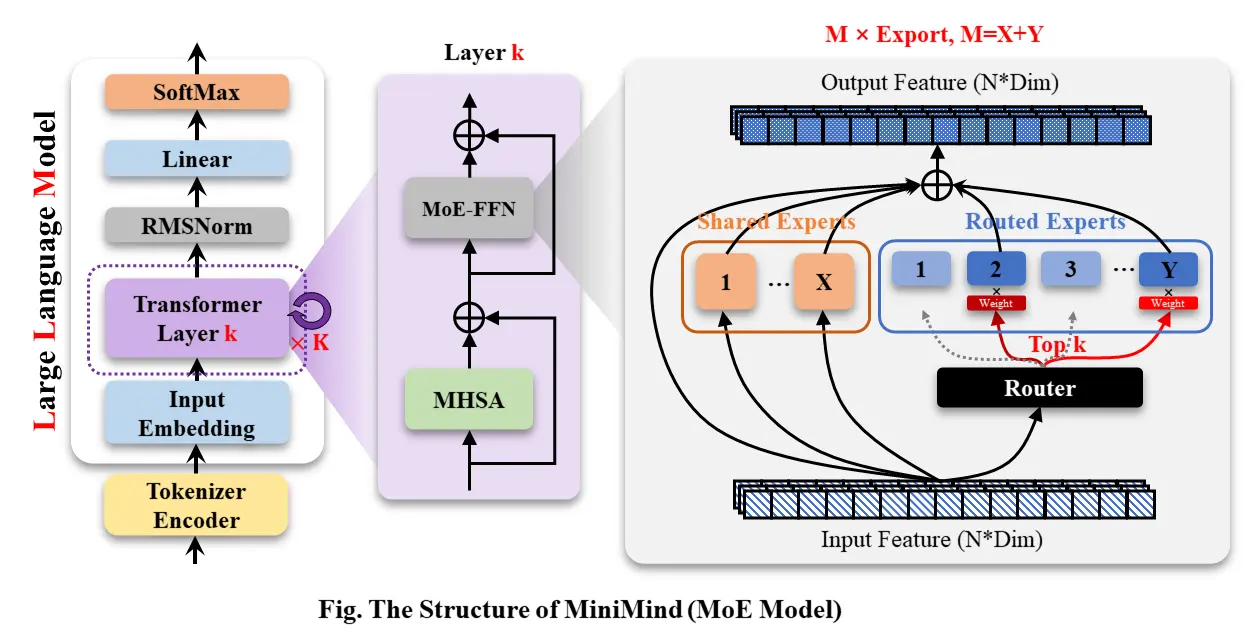

MiniMind-LLM 结构的全部代码(Dense+MoE 模型)。

包含 Tokenizer 分词器详细训练代码。

包含 Pretrain、SFT、LoRA、RLHF-DPO、模型蒸馏的全过程训练代码。

收集、蒸馏、整理并清洗去重所有阶段的高质量数据集,且全部开源。

从 0 实现预训练、指令微调、LoRA、DPO 强化学习,白盒模型蒸馏。关键算法几乎不依赖第三方封装的框架,且全部开源。

同时兼容 transformers、trl、peft 等第三方主流框架。

训练支持单机单卡、单机多卡 (DDP、DeepSpeed) 训练,支持 wandb 可视化训练流程。支持动态启停训练。

在第三方测评榜(C-Eval、C-MMLU、OpenBookQA 等)进行模型测试。

实现 Openai-Api 协议的极简服务端,便于集成到第三方 ChatUI 使用(FastGPT、Open-WebUI 等)。

基于 streamlit 实现最简聊天 WebUI 前端。

复现 (蒸馏 / RL) 大型推理模型 DeepSeek-R1 的 MiniMind-Reason 模型,数据 + 模型全部开源。

MiniMind 的整体结构一致,只是在 RoPE 计算、推理函数和 FFN 层的代码上做了一些小调整。 其结构如下图: